Una empresa debe pedir disculpas a todos sus usuarios: la IA que tienen se inventó una política que indignó a todos

Donde esté el trato humano en la atención al cliente, que se quite la IA

Como consumidor, valoro muchísimo la atención al cliente de las empresas. Que haya una persona de carne y hueso disponible, ya sea por llamada telefónica o chat, para resolver mis dudas sobre un producto o servicio en el menor tiempo posible, suma muchos puntos a la experiencia de usuario, incrementando las probabilidades de que continúe confiando en ellas en el futuro.

Por desgracia, la calidad es cada vez peor. Para recortar gastos —mejor dicho, puestos de trabajo—, muchas empresas están reemplazando a los seres humanos por bots diseñados específicamente para «ayudar» con problemas derivados de los pedidos realizados o consultas relacionadas con lo ofertado en la tienda online. La mayoría de las veces las respuestas no solo dejan mucho que desear, sino que pueden provocar nuevos interrogantes.

Todo parecía indicar que la inteligencia artificial haría que los bots de soporte para atención al cliente se volverían mucho más útiles al integrar la tecnología de moda. Nada más lejos de la realidad. Ahora no solo ofrecen respuestas que sacan de quicio incluso al más paciente, sino que se inventan políticas que provocan la indignación de los usuarios.

Un nuevo caso de «alucinaciones» de IA

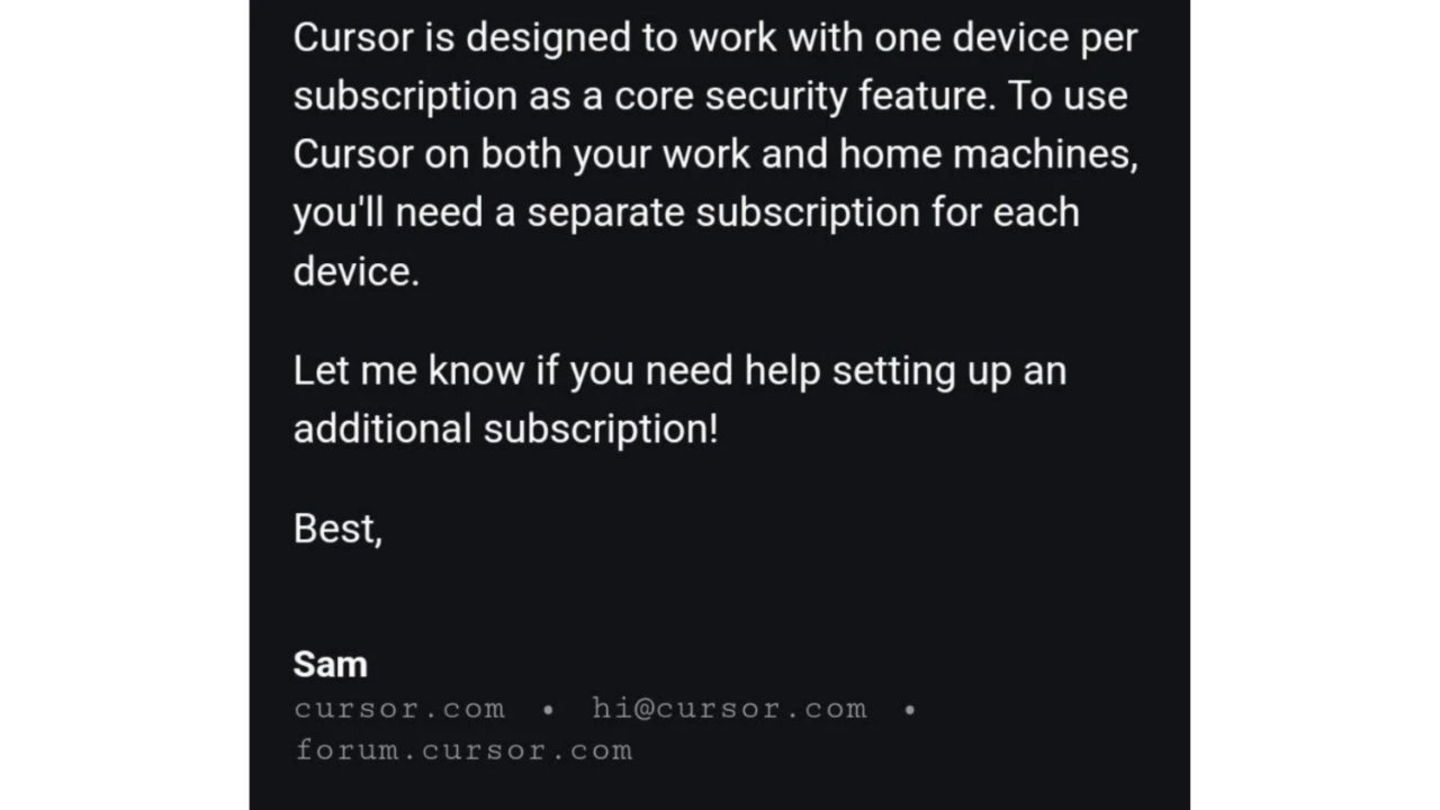

Captura de pantalla del usuario BrokenToasterOven con la respuesta del bot Sam

Cursor es un editor de código que emplea la inteligencia artificial de grandes modelos lingüísticos para ayudar a los desarrolladores con su trabajo, ofreciendo sugerencias de autocompletado y reescritura para mayor eficiencia. Recientemente, un usuario sufrió un problema que le impedía trabajar con normalidad: al cambiar de máquina, la sesión se cerraba instantáneamente, interrumpiendo su flujo de trabajo.

Interesado en una solución, el usuario contactó con el servicio de atención al cliente de Cursor. Rápidamente, un tal Sam le indicó que el comportamiento que había experimentado era completamente normal debido a una nueva «política» de la herramienta. Lo curioso es que dicha política no existe, y Sam no era una persona, sino un chatbot.

La experiencia corrió como la pólvora en Hacker News y Reddit, desencadenando una ola de indignación y quejas por parte de los usuarios, así como amenazas de cancelación de la suscripción (según el sitio web, 20 dólares al mes por la modalidad Pro para acceder a las características de manera ilimitada, o 40 dólares al mes y por usuario en la modalidad Business).

No es más que otra «alucinación». La inteligencia artificial es propensa a las alucinaciones, término que hace referencia a los resultados incorrectos o engañosos que generan los modelos de esta tecnología. Pueden suceder por diversas causas, como no haber proporcionado la cantidad suficiente de datos para un óptimo entrenamiento. Es uno de los motivos por los que no se debe utilizar ChatGPT o herramientas similares, como Copilot, Gemini o Grok en el trabajo. Este despacho de abogados lo aprendió por las malas en un juicio.

Un portavoz de Cursor, a través del hilo de Reddit, comentó: "Oye, no tenemos esa política", asegurando que "Por supuesto, puedes usar Cursor en varias máquinas. Lamentablemente, esta es una respuesta incorrecta de un bot de soporte de IA". Los usuarios que utilizan diariamente el editor de código potenciado con inteligencia artificial pueden respirar tranquilos: pueden seguir usando Cursor en varios dispositivos al mismo tiempo. Pero puede que la confianza de los suscriptores no vuelva a ser la misma.