Los usuarios de ChatGPT han descubierto una cosa que no les ha gustado nada: aparecen en las búsquedas de Google

Ten cuidado si lo usas como confidente

Si creías que tus charlas con ChatGPT eran cosa privada, va siendo hora de replanteárselo. En un giro digno de una distopía digital, miles de conversaciones personales aparecieron indexadas en los resultados de búsqueda de Google, al alcance de cualquiera con un poco de curiosidad y buena puntería. Sí, hablamos de chats con confesiones íntimas, relaciones familiares, experiencias traumáticas y hasta problemas de salud mental o consumo de drogas. Todo, al descubierto.

El escándalo estalló esta semana después de una investigación de Fast Company, que encontró no solo unos cuantos chats sueltos, sino miles. Y, lo que es peor, advirtió que eso probablemente era solo “una muestra” de lo que había disponible para millones de usuarios.

Todo por tocar una casilla

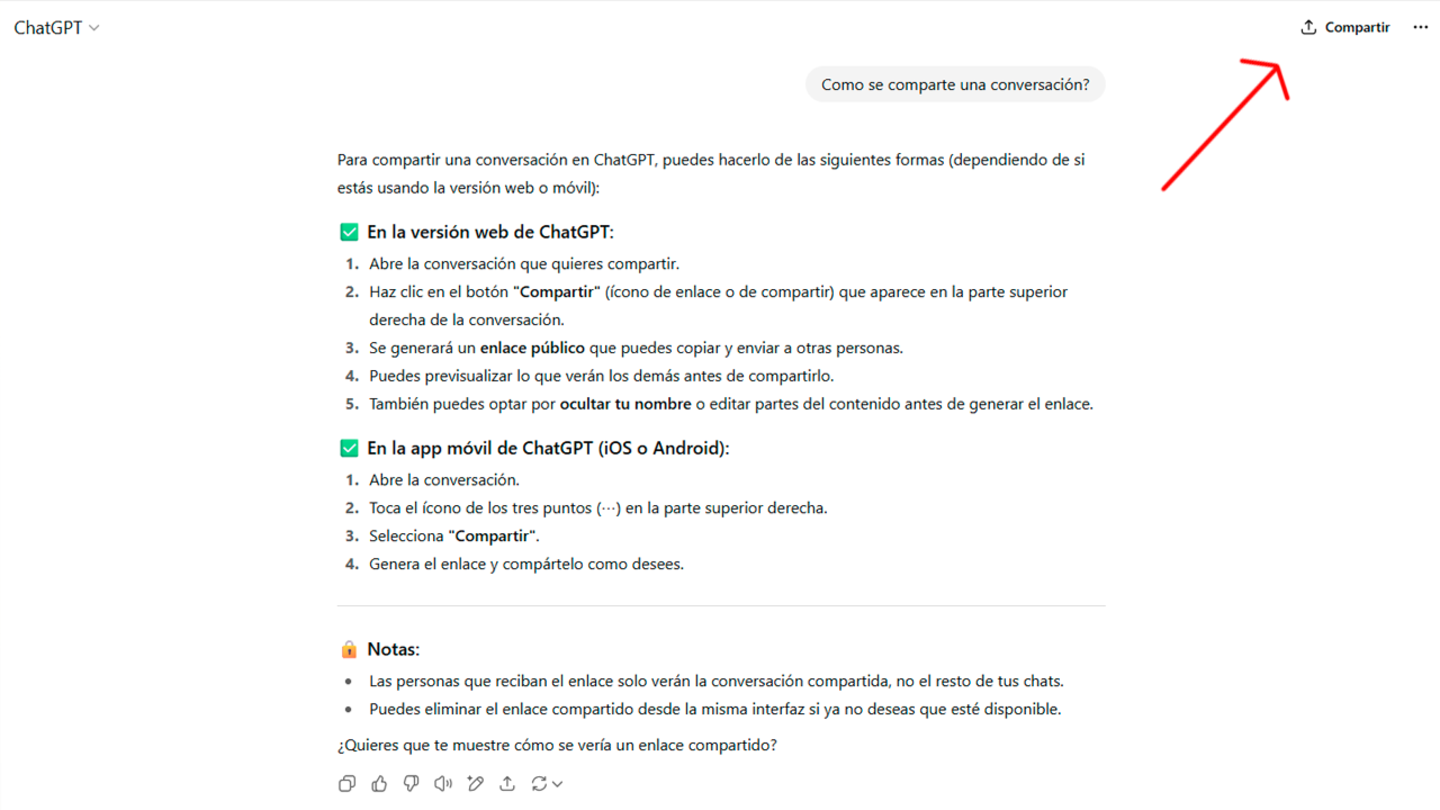

La clave está en una función que OpenAI había introducido discretamente: un botón para “compartir” conversaciones. Cuando el usuario hacía clic ahí, aparecía una casilla que decía “Hacer este chat descubrible”, acompañada de un texto más pequeño —y fácil de pasar por alto— que advertía que esa charla podía acabar apareciendo en los motores de búsqueda.

La intención, según OpenAI, era “ayudar a la gente a descubrir conversaciones útiles”. Pero claro, lo que muchos usuarios querían era simplemente guardar el enlace para revisarlo después o compartirlo por WhatsApp con algún amigo. Lo que no sabían es que al marcar esa casilla (a veces por accidente o por no leer la letra pequeña), estaban exponiendo su vida privada al escaparate público de Internet.

El responsable de seguridad de la compañía, Dane Stuckey, ha intentado quitar hierro al asunto diciendo que “todos los usuarios que compartieron chats con Google lo hicieron activamente”. Pero lo cierto es que esa “actividad” era más bien un desliz provocado por un diseño poco claro. Tanto es así, que OpenAI ha reculado y eliminado la función por completo.

Lo más inquietante de todo el asunto es que no fue Google quien indexó esas páginas por iniciativa propia. Tal y como ha explicado un portavoz de la compañía a Ars Technica, “los motores de búsqueda no controlan qué páginas son públicas en la web. Son los propietarios de los sitios quienes deciden si se indexan o no.” Es decir: la culpa es enteramente de OpenAI.

Esta es la información que te da ChatGPT sobre cómo compartir tus datos

Han dado marcha atrás, pero el daño está hecho y el futuro no pinta muy privado

Tras la oleada de críticas, OpenAI ha dicho que va a pedir a Google que elimine todas las páginas indexadas con chats públicos. Y lo hará con una herramienta especial para bloquear esos enlaces en los resultados. El problema es que esta medida no es automática ni universal: puede que los chats desaparezcan antes de Google que de otros buscadores, y además, no hay garantía de que no se hayan guardado en algún archivo o repositorio por ahí.

La compañía ha calificado la función como “un experimento de corta duración”, pero eso no ha calmado los ánimos. No solo por la brecha de privacidad, sino también porque llega en un momento especialmente sensible. Hace apenas unas semanas, OpenAI perdió una batalla legal que le obligará a conservar indefinidamente los chats borrados por los usuarios, algo que muchos consideran una traición directa a la promesa de confidencialidad que vendía ChatGPT desde el principio.

Y mientras tanto, Sam Altman —el CEO de OpenAI— se ha limitado a admitir que “es una liada que los chats privados puedan aparecer en buscadores”, pero sin lanzar críticas claras a las prácticas de su propia empresa.

Muchos usan ChatGPT como un confidente digital. Le cuentan cosas que no se atreven a decir en voz alta. Consultan dudas delicadas, escriben cartas personales, o simplemente se desahogan. ¿Quién pensaría que todo eso podría acabar en Google?

Más allá de lo que OpenAI haga ahora para tapar el agujero, lo que preocupa es la tendencia. El escándalo pone sobre la mesa un problema que va mucho más allá de un simple error de diseño: la creciente falta de control que tenemos los usuarios sobre nuestra información cuando interactuamos con herramientas de inteligencia artificial.

Este caso es una llamada de atención brutal sobre cómo las empresas tecnológicas gestionan nuestra privacidad. Porque no basta con esconder una advertencia en letra pequeña y decir que “el usuario aceptó”. La responsabilidad está en el diseño, en la claridad, y en no poner en riesgo la confianza de millones por una simple “prueba”.