NVIDIA presenta su primera IA desarrollada para los vehículos autónomos

Un nuevo modelo de inteligencia artificial promete vehículos capaces de explicar sus decisiones, anticipar riesgos complejos y navegar entornos imprevisibles

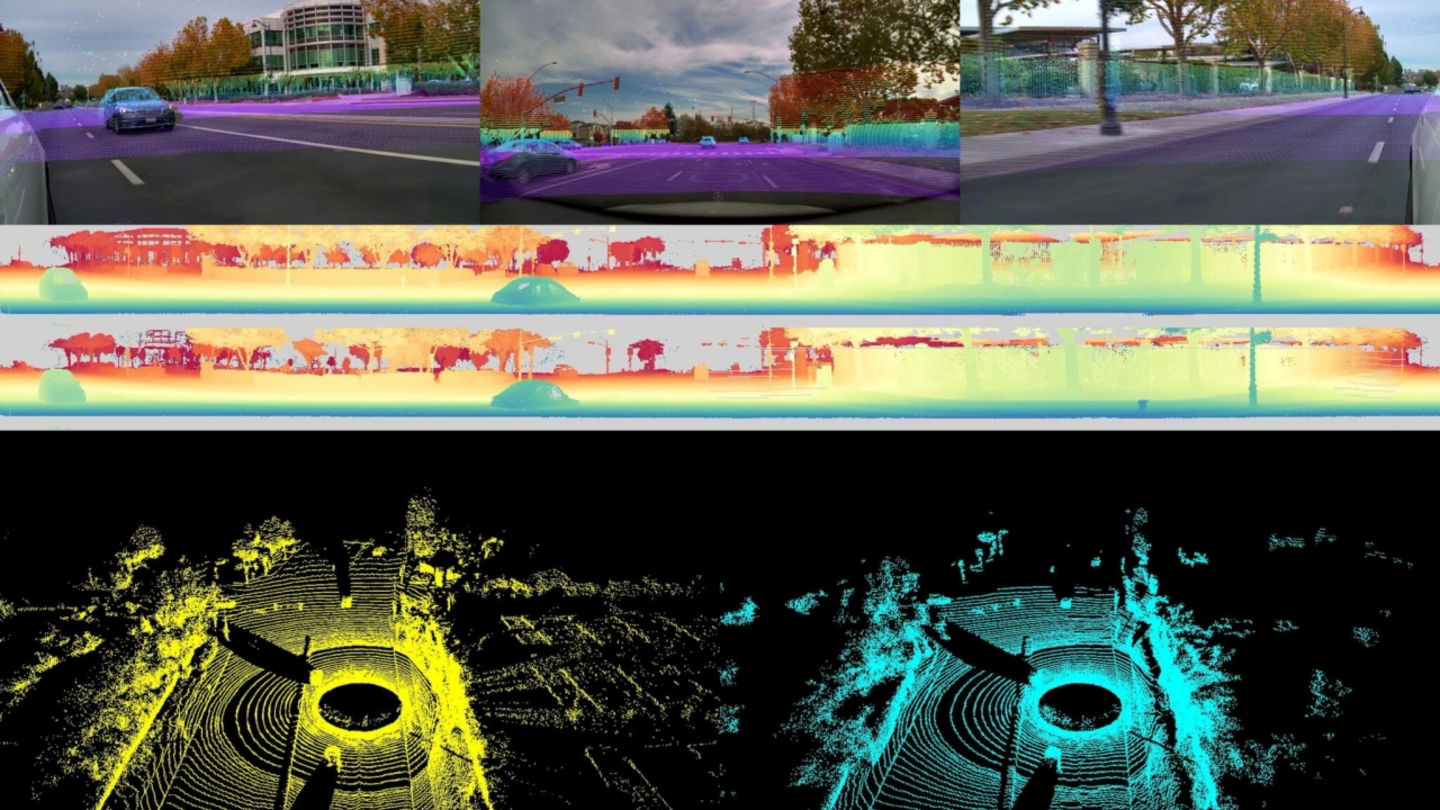

NVIDIA ha aprovechado NeurIPS, una de las conferencias de inteligencia artificial más importantes y prestigiosas del mundo, para presentar DRIVE Alpamayo-R1. Este es el primer modelo de razonamiento visual-lingüístico-de acción de escala industrial que se libera de forma abierta, un movimiento poco habitual en un sector donde los algoritmos suelen guardarse en una caja acorazada. ¿Su objetivo? Dotar a los vehículos autónomos de algo parecido al sentido común.

Un modelo que aprende a razonar como un humano

Hasta ahora, la mayor parte de sistemas autónomos se limitaba a reconocer objetos y reaccionar a ellos con reglas predefinidas. Funcionan razonablemente bien cuando la situación es sencilla, pero ante el caos de la circulación real suelen volverse torpes y peligrosos. Alpamayo-R1, en cambio, introduce un cambio de enfoque, ya que no se limita reaccionar, sino que interpreta, razona y decide.

La clave de este modelo es su capacidad para descomponer cada escena en una cadena de pasos lógicos. Primero analiza todos los elementos del entorno, luego plantea varias trayectorias posibles y, finalmente, selecciona la que mejor equilibra seguridad y eficiencia. Lo interesante del modelo es que es capaz de explicar su razonamiento.

El modelo de NVIDIA puede comprender y razonar con el entorno

El sistema no solo decide, sino que también explica lo que hace. Deja una especie de huella que muestra por qué se apartó de un ciclista, por qué tomó un desvío o por qué frenó antes de que un peatón cruzara. Esas explicaciones serán de gran ayuda para que la gente confíe más en el coche autónomo y facilitará que los reguladores entiendan cómo actúa.

Además, el modelo mejora con la práctica. Gracias al aprendizaje por refuerzo, va afinando sus decisiones a medida que se expone a más situaciones. De hecho, según la información publicada en la página web de NVIDIA, la compañía ya ha observado que en la fase de entrenamiento el modelo se ha vuelto más cauteloso, flexible y capaz de manejar detalles que antes se le escapaban. Además, Alpamayo-R1 no estará aislado.

Y este modelo no funciona solo. Está construido sobre Cosmos Reason, la tecnología de NVIDIA que permite ajustar el modelo, crear datos artificiales para entrenarlo en situaciones poco habituales y probarlo en simuladores muy realistas. Los investigadores pueden acceder al código, modificarlo y crear sus propias versiones, algo que hace unos años era impensable en este sector. El modelo ya se puede descargar en GitHub y Hugging Face, junto con parte de los datos usados para entrenarlo y con AlpaSim, una herramienta para ponerlo a prueba.

Con esta estrategia abierta, NVIDIA quiere acelerar el avance en conducción autónoma e intentar que los coches del futuro sean más fáciles de entender, más seguros y más fiables. El cambio es importante: los vehículos autónomos ya no solo verán, sino que sabrán como reaccionar.