OpenAI se vuelve cada vez abierto: lanza sus primeros modelos de IA open source en cinco años

Pero aún no lo es del todo.

Cinco años después de haber cerrado el grifo del código abierto, OpenAI ha decidido dar marcha atrás, al menos un poco. La compañía acaba de anunciar el lanzamiento de dos nuevos modelos de IA de código abierto, es decir, disponibles para cualquiera que los quiera descargar, probar o integrar en sus propios proyectos. ¿Su nombre? GPT-OSS. ¿Su objetivo? Volver a conquistar el corazón de los desarrolladores y poner freno al avance de China en la carrera de la inteligencia artificial abierta.

Remontando desde el lado equivocado de la historia

Porque OpenAI llevaba años apostando por el modelo cerrado. Desde GPT-3, sus avances en IA han sido accesibles solo a través de su API, bajo control total de la empresa. Eso le ha dado muchos ingresos, sí, pero también muchas críticas por alejarse de su misión fundacional: “garantizar que la inteligencia artificial beneficie a toda la humanidad”.

Sam Altman, CEO de OpenAI, lo reconoció en enero: “Estábamos en el lado equivocado de la historia con respecto al código abierto”. Y no es casualidad que esta apertura llegue justo cuando empresas chinas como DeepSeek, Moonshot o Qwen están arrasando con modelos abiertos muy potentes. Incluso Meta, que antes lideraba el sector con LLaMA, ha perdido algo de fuelle.

Así que, entre la presión del mercado, las críticas de la comunidad de desarrolladores, y un empujoncito del gobierno estadounidense (sí, la administración Trump ha pedido a las empresas que compartan más públicamente el avance de las IA), OpenAI se ha puesto las pilas.

La cosa mejora, pero siguen alucinando

Según OpenAI, los nuevos GPT-OSS son “punteros” entre los modelos abiertos. En pruebas como Codeforces (relacionadas con programación competitiva), superan a los modelos de DeepSeek, aunque todavía están por debajo de los modelos cerrados más avanzados de la propia compañía, como o3 y o4-mini.

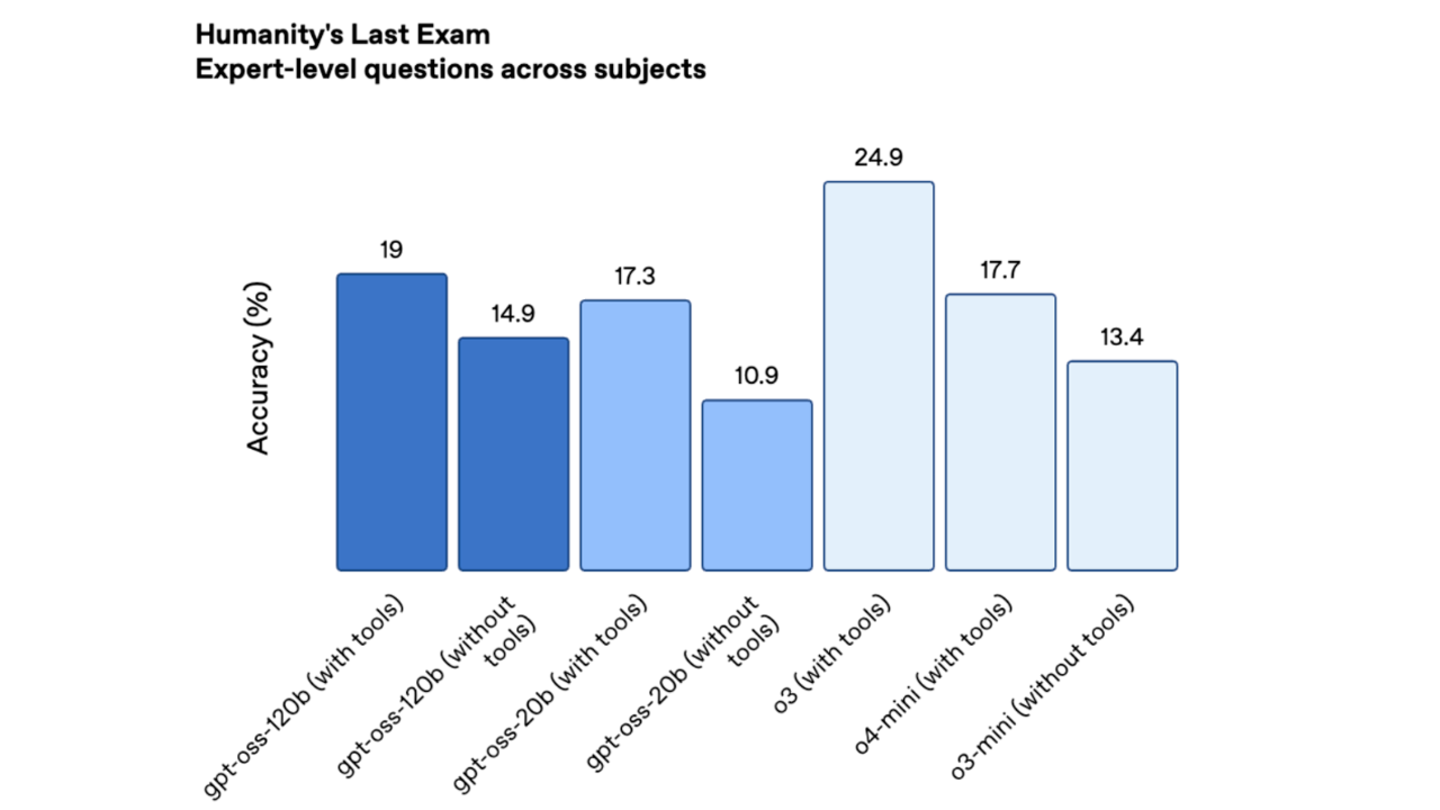

En otro test exigente, llamado Humanity’s Last Exam (HLE), los resultados son similares: mejores que la competencia abierta, pero sin llegar al nivel de los modelos más punteros y cerrados de OpenAI.

Su performance sigue por debajo de algunos de su competidores, pero mejora con respecto a modelos anteriores.

Pero ojo, porque no todo es perfecto. Estos nuevos modelos tienden a “alucinar” más (es decir, a inventarse respuestas) que los modelos más grandes. En el benchmark PersonQA, especializado en evaluar conocimientos sobre personas, los GPT-OSS alucinaron casi la mitad de las veces (49% y 53%), frente al 16% de o1 y el 36% de o4-mini. ¿La explicación? Son modelos más pequeños y, como tal, tienen menos “conocimiento del mundo”. Algo normal, según la propia OpenAI.

¿Pero cómo de "abiertos" son?

Aquí está el truco. Aunque los modelos están disponibles bajo licencia Apache 2.0, una de las más permisivas, y pueden usarse incluso para fines comerciales sin pagar a OpenAI, la empresa no ha liberado los datos con los que entrenó estos modelos.

Esto no debería sorprender a nadie. Hay varias demandas activas contra compañías de IA (incluida OpenAI) por haber usado material protegido por derechos de autor para entrenar sus sistemas. Así que, por ahora, el código sí, pero los datos no.

Además, OpenAI retrasó el lanzamiento varias veces para revisar los riesgos de seguridad. En un informe técnico, la empresa admite que investigó si los modelos GPT-OSS podrían ser usados por actores maliciosos para mejorar ciberataques o desarrollar armas biológicas. ¿El resultado? Detectaron un “aumento marginal” de capacidad en biología, pero nada que alcanzara su umbral de peligro. Por eso, finalmente, los han liberado.

Los dos modelos —gpt-oss-120b y gpt-oss-20b— ya están disponibles en Hugging Face, la popular plataforma para compartir modelos de IA. El primero es más potente y puede funcionar en una sola GPU de Nvidia, mientras que el segundo es ligero y se puede usar incluso desde un portátil con 16 GB de RAM. En resumen: no necesitas una supercomputadora para jugar con ellos.

Eso sí, todavía queda mucho por ver. OpenAI no ha dicho si estos modelos serán los únicos “abiertos” o si habrá más en el futuro. Tampoco se sabe si actualizarán los modelos con mejoras o parches de seguridad de forma continua. Mientras tanto, la competencia no se queda quieta. DeepSeek ya prepara su modelo R2, que podría superar en rendimiento a estos GPT-OSS, y Meta está cocinando una nueva generación de modelos abiertos desde su Superintelligence Lab.