La inteligencia artificial no hace bien su trabajo de científica: se inventa las fuentes y ocurre más veces de lo que debería

El 60% de las veces, la IA se inventa las fuentes, lo que demuestra que todavía no es una buena científica

El público general lleva poco tiempo pudiendo acceder a la inteligencia artificial. El primer sistema que se popularizó a nivel mundial fue ChatGPT, el bot conversacional desarrollado por OpenAI, la compañía liderada por Sam Altman y cofundada por Elon Musk hace una década. Fue lanzado a finales de 2022 y, desde entonces, ha evolucionado mucho, siendo más inteligente y funcionando como un motor de búsqueda de Internet, rivalizando así con Google.

Para mucha gente, los bots conversacionales como Claude o Copilot se han convertido en herramientas indispensables en su día a día, ya que los ayuda a realizar sus tareas, buscar información y adquirir nuevos conocimientos de forma rápida y sencilla; a golpe de clic. A pesar de sus avances, todavía tienen mucho por mejorar, ya que no se puede confiar en ellos al 100%.

Muchas personas utilizan estos sistemas basados en inteligencia artificial para descubrir fuentes que añadir a sus investigaciones y proyectos. Y es un gran error. Un reciente estudio ha desvelado que los motores de búsqueda basados en IA citan fuentes incorrectas muchas más veces de lo que la gente creería. Conviene contrastar la información para no hacer el ridículo como este importante bufete de abogados.

Grok 3 tiene la tasa de error más alta: un 94%

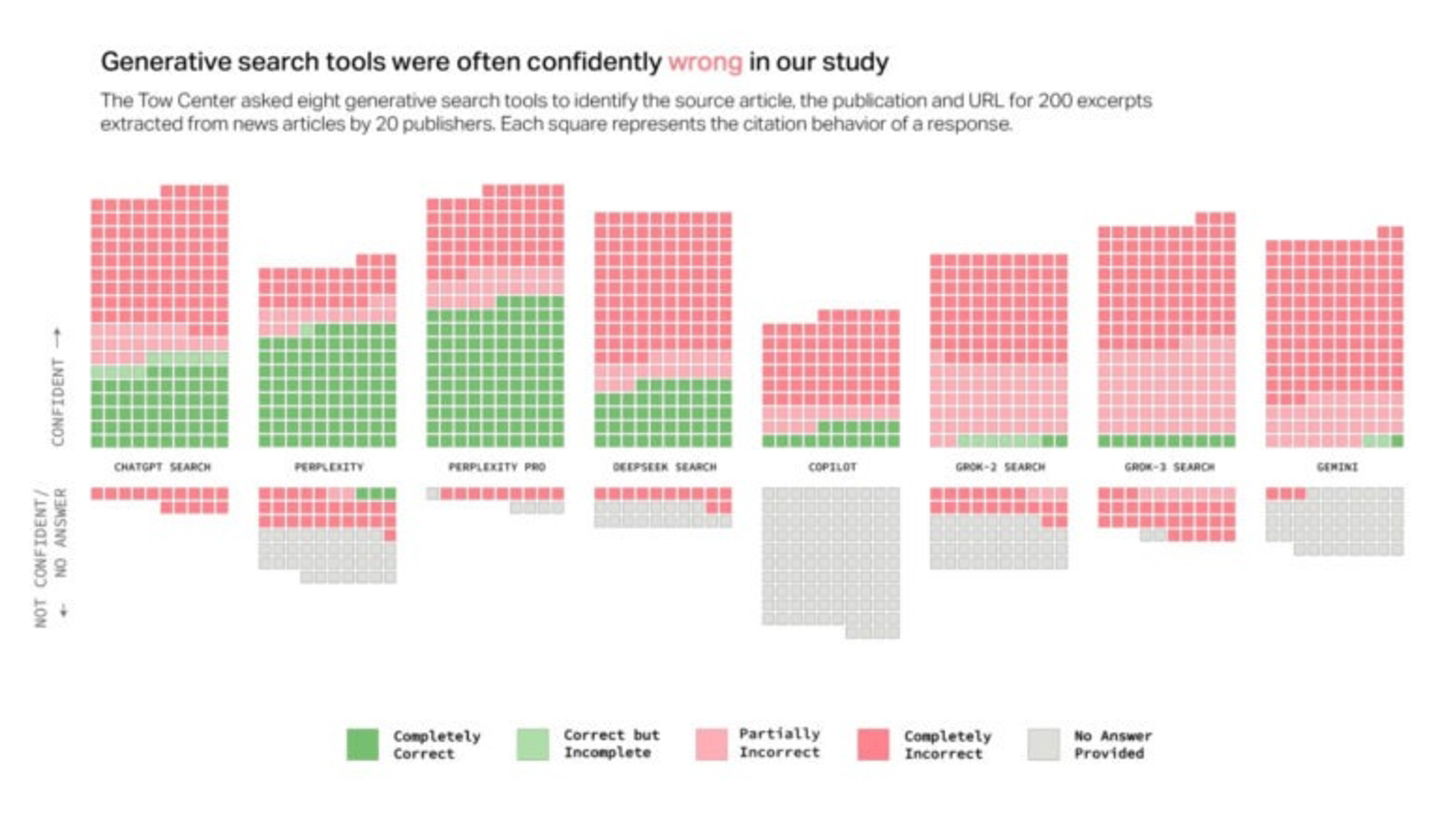

Gráfico que muestra los errores de las herramientas | Imagen de CJR

Un nuevo estudio del Centro Tow para el Periodismo Digital de Columbia Journalism Review ha revelado que todavía no nos podemos fiar de la inteligencia artificial para investigaciones. El experimento tuvo en cuenta ocho herramientas de búsqueda basadas en IA que tienen la función de búsqueda en tiempo real, y descubrió que los modelos respondían incorrectamente a más del 60% de consultas sobre fuentes de noticias.

La tasa de error varió notablemente entre las herramientas analizadas. La que salió mejor parada fue Perplexity, que proporcionó información incorrecta en "solo" el 37% de las consultas. Por su parte, ChatGPT, que es uno de los más utilizados en todo el mundo, identificó incorrectamente el 67% de los artículos consultados.

El menos recomendable para realizar consultas es Grok 3. La inteligencia artificial de xAI, compañía fundada por Elon Musk en 2023 y que está especializada en esta tecnología, presentó la tasa de error más alta, un 94%. Es muy llamativo este dato, ya que el CEO de Tesla asegura que tiene un rendimiento similar a las alternativas de OpenAI y Anthropic.

Para las pruebas, los investigadores alimentaron los modelos de IA con extractos directos de artículos periodísticos reales y pidieron a cada modelo que identificar el titular del artículo, la editorial original, la fecha de publicación y el enlace URL. En total, ejecutaron 1.600 consultas en las ocho herramientas de búsqueda con IA.

El estudio descubrió que los modelos, en lugar de negarse a responder cuando carecían de información fiable, proporcionaban fabulaciones (respuestas incorrectas o especulativas que parecían plausibles). Los investigadores aseguran que el comportamiento se dio en todas las herramientas, aunque en unas es más exagerado que en otras, como recoge la fuente.

Como curiosidad: las modalidades de pago de las herramientas obtuvieron todavía peores resultados. Además, algunas herramientas ignoraron la configuración del Protocolo de Exclusión de Robots (ROP), utilizado para evitar el acceso no autorizado, con el objetivo de hacerse con extractos de contenido de pago de medios como National Geographic.